6.2 Variables latentes

Un caso importante de datos faltantes es cuando una variable está totalmente censurada. Esto puede suceder por dos razones:

Alguna variable claramente importante está totalmente censurada (por ejemplo, peso en un estudio de consumo de calorías).

Cuando buscamos añadir estructura a nuestro modelo para simplificar su estimación, interpretación o forma. Por ejemplo: hacer grupos de actitudes ante la comida y el ejercicio para explicar con una sola variable el consumo de comida chatarra (por ejemplo, análisis de factores).

En estos casos, estas variables se llaman variables latentes, pues consideramos que tienen un efecto que observamos a través de otras variables, pero no podemos observar directamente los valores de esta variable.

¿Cuál es el supuesto apropiado acerca

de este tipo de valores censurados (variables latentes)?

¿Cuál es el supuesto apropiado acerca

de este tipo de valores censurados (variables latentes)?

- MCAR

- MAR

- MNAR

- Ninguno de estos

La siguiente tabla es una clasificación de los modelos de variable latente de acuerdo a la métrica de las variables latentes y observadas.

| Latentes/Observadas | Métricas | Categóricas |

|---|---|---|

| Métricas | Análisis de factores (FA) | Modelos de rasgos latentes (LTM) |

| Categóricas | Modelos de perfiles latentes (LPM) | Modelos de clases latentes (LCM) |

6.2.1 Modelos de perfiles latentes: Mezcla de normales

El ejemplo más clásico de variables latentes es el de mezcla de normales.

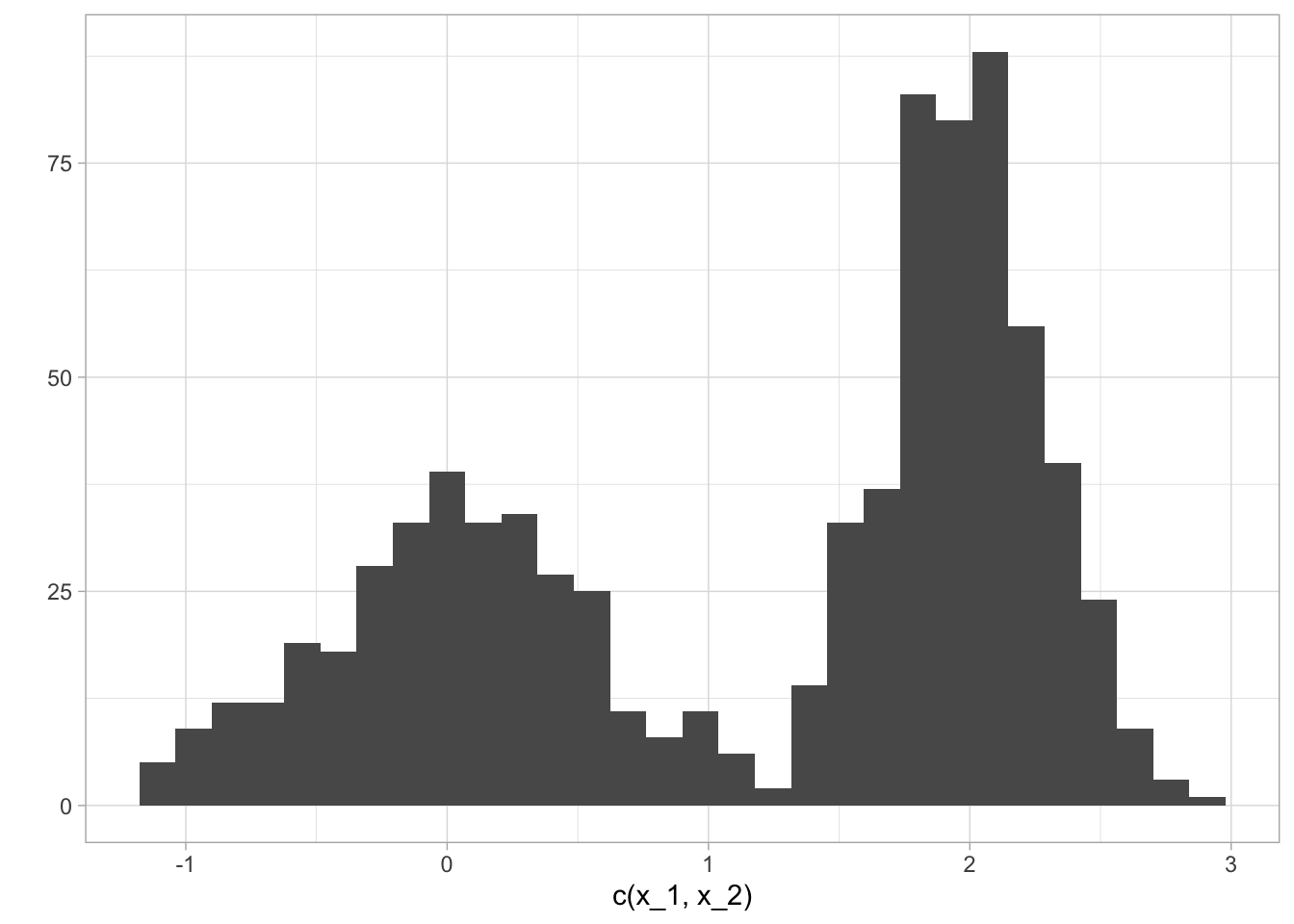

Ejemplo. Modelo de mezcla de dos normales. Consideremos los siguientes datos:

library(ggplot2)

set.seed(280572)

N <- 800

n <- sum(rbinom(N, 1, 0.6))

x_1 <- rnorm(N - n, 0, 0.5)

x_2 <- rnorm(n, 2, 0.3)

qplot(c(x_1, x_2))

#> `stat_bin()` using `bins = 30`. Pick better value with `binwidth`.

Estos datos tienen una estructura bimodal. Es poco apropiado modelar estos datos con un modelo normal .

Podemos entonces modelar pensando que los datos vienen de dos clases, cada una con una distribución normal pero con distintos parámetros. ¿Cómo ajustaríamos tal modelo?

La variable aleatoria es una mezcla de normales si donde es una densidad normal con parámetros y los ponderadores de la mezcla satisfacen

Ahora, si vemos la mezcla Gaussiana desde la representación generativa, o formulación en variable latente, tenemos el modelo gráfico -> donde es una indicadora de clase. En el caso del modelo de dos clases tenemos y sea , escribimos la conjunta

y podemos verificar que la distribución marginal es una mezcla gaussiana:

Ahora, si conocieramos la clase a la que pertenece cada observación () podríamos escribir la log-verosimilitud completa (sin censura) como

Aquí, es fácil ver que la verosimilitud se separa en dos partes, una para y otra para , y los estimadores de máxima verosimilitud son entonces:

y es la proporción de casos tipo 1 en los datos. Este problema es entonces trivial de resolver.

En el caso de variables latentes están censuradas y tenemos que marginalizar con respecto a , resultando en:

donde es la probabilidad de que la observación venga de la primera densidad. Este problema es más difícil pues tenemos tanto como y dentro del logaritmo. Podemos resolver numéricamente como sigue:

crearLogLike <- function(x){

logLike <- function(theta){

pi <- exp(theta[1]) / (1 + exp(theta[1]))

mu_1 <- theta[2]

mu_2 <- theta[3]

sigma_1 <- exp(theta[4])

sigma_2 <- exp(theta[5])

sum(log(pi*dnorm(x, mu_1, sd=sigma_1)+(1-pi)*dnorm(x,mu_2,sd=sigma_2)))

}

logLike

}

func_1 <- crearLogLike(c(x_1,x_2))

system.time(salida <- optim(c(0.5,0,0,1,1), func_1, control=list(fnscale=-1)))

#> user system elapsed

#> 0.026 0.001 0.027

salida$convergence

#> [1] 0

exp(salida$par[1]) / (1 + exp(salida$par[1]))

#> [1] 0.5857074

salida$par[2:3]

#> [1] 1.98759218 0.03046366

exp(salida$par[4:5])

#> [1] 0.2977028 0.5159818Y vemos que hemos podido recuperar los parámetros originales.

Ahora implementamos EM para resolver este problema. Empezamos con la log-verosimilitud para datos completos (que reescribimos de manera más conveniente):

Tomamos valores iniciales para los parámetros y comenzamos con el paso Esperanza promediando sobre las variables aleatorias, que en este caso son las . Calculamos entonces y usamos bayes para expresar en términos de los parámetros:

se conocen como la responsabilidad del modelo 1 para explicar la i-ésima observación.

Utilizando estas asignaciones de los faltantes pasamos al paso Maximización, donde la función objetivo es:

La actualización de es fácil:

y se puede ver sin mucha dificultad que

Implementa EM para el ejemplo de

mezcla de normales.

Implementa EM para el ejemplo de

mezcla de normales.